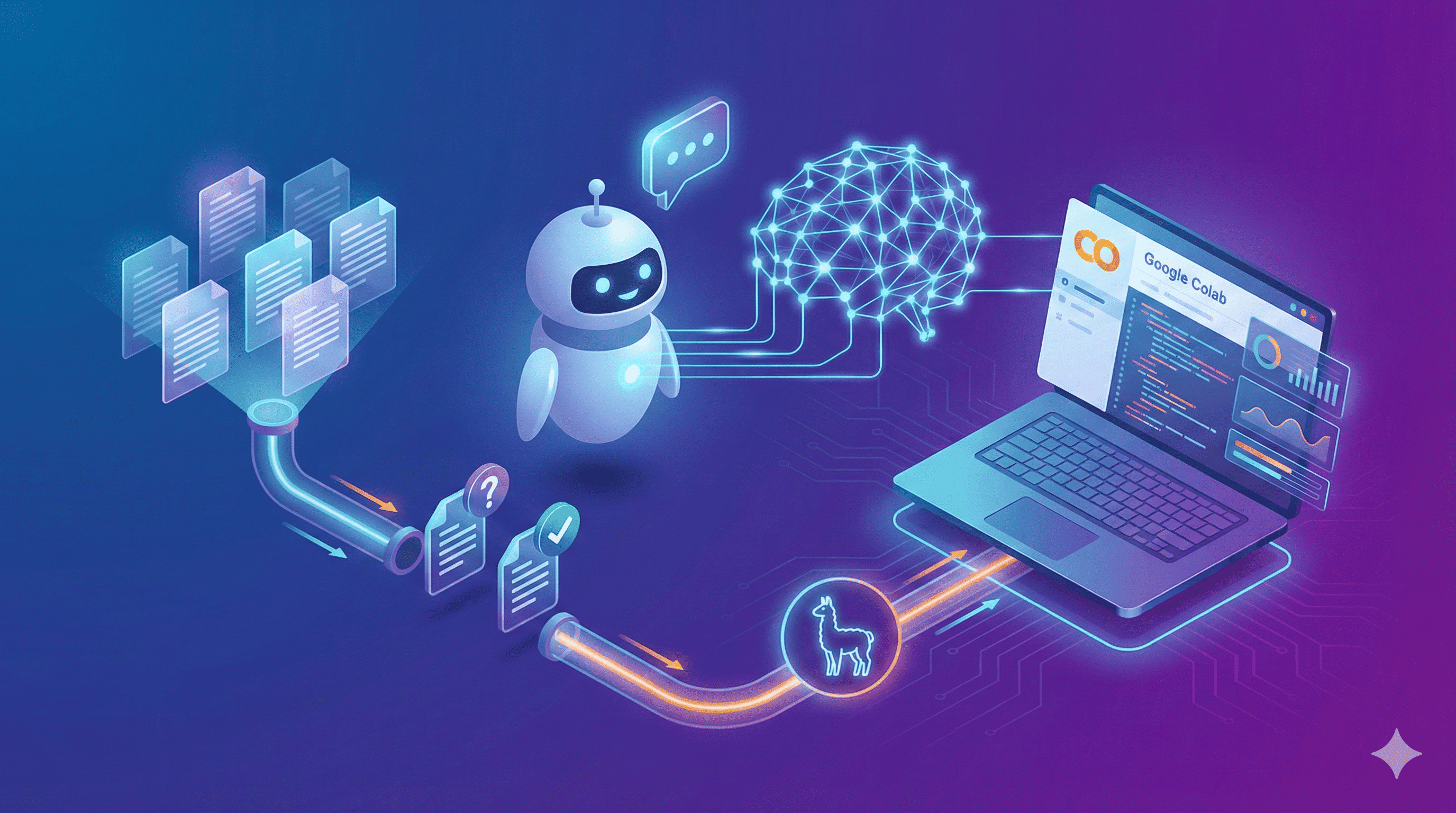

Vuoi creare un chatbot che risponda a domande specifiche sulla tua base di conoscenze ma senza dover implementare un sistema RAG complesso? Con il fine-tuning di un modello LLM puoi ottenere un chatbot che ha le informazioni letteralmente integrate nei suoi parametri neurali. In questa guida vedrai come utilizzare Easy Dataset per preparare i dati e LLaMA Factory per il training, il tutto su un notebook Google Colab gratuito.

Il fine-tuning è particolarmente utile quando hai una base di conoscenze ben definita che non cambia frequentemente. A differenza del RAG che deve recuperare informazioni da database esterni ad ogni domanda, un modello sottoposto a fine-tuning risponde in modo più fluido e naturale perché la conoscenza fa già parte della sua struttura interna.

Prepara il Dataset con Easy Dataset

Il primo step fondamentale è creare un dataset di qualità. Qui entra in gioco Easy Dataset, uno strumento pensato proprio per semplificare questa fase che altrimenti richiederebbe ore di lavoro manuale. La sua forza sta nella capacità di trasformare i tuoi documenti in coppie strutturate di domande e risposte, esattamente il formato che serve per addestrare il chatbot.

Per iniziare carica i documenti che contengono la conoscenza che vuoi trasferire al modello. Possono essere manuali, guide, articoli o qualsiasi altra fonte testuale. Easy Dataset analizza il contenuto e genera automaticamente domande pertinenti insieme alle relative risposte estratte dal testo originale. Questo ti fa risparmiare tantissimo tempo rispetto alla creazione manuale di centinaia di esempi.

Lo strumento è intelligente nel comprendere il contesto e nel formulare domande che rispecchiano il modo in cui un utente reale interrogherebbe il sistema. Tuttavia non devi affidarti ciecamente all'automazione. Dopo la generazione automatica rivedi almeno un campione rappresentativo delle coppie generate, verificando che le domande abbiano senso e che le risposte siano accurate. Questo controllo qualità è essenziale perché il modello imparerà esattamente ciò che gli insegni: se i dati contengono errori, questi si rifletteranno nelle risposte del chatbot finale.

Il formato del dataset prodotto da Easy Dataset è tipicamente compatibile con i principali framework di fine-tuning, quindi la transizione alla fase successiva sarà fluida. Ogni esempio dovrebbe contenere una domanda chiara, una risposta dettagliata ma concisa, e possibilmente un contesto che aiuti il modello a capire l'ambito dell'informazione.

Configura LLaMA Factory per il Training

Una volta pronto il dataset entriamo nel vivo del processo con LLaMA Factory, il framework che utilizzerai per il fine-tuning vero e proprio. LLaMA Factory si distingue perché rende accessibile un processo tecnicamente complesso, offrendo un'interfaccia che bilancia semplicità d'uso e controllo sui parametri di training.

LLaMA Factory supporta numerosi modelli della famiglia LLaMA e non solo, permettendoti di scegliere il modello base più adatto alle tue esigenze. Per un chatbot specializzato ti consiglio di partire da modelli di dimensioni medie come LLaMA 2 7B o 13B, che offrono un ottimo compromesso tra capacità e requisiti hardware. Modelli più grandi possono dare performance superiori ma richiedono risorse significativamente maggiori che potrebbero superare i limiti di Colab.

Uno dei grandi vantaggi di LLaMA Factory è che gestisce automaticamente il download dei modelli da Hugging Face. Non devi preoccuparti di cercare manualmente i file del modello o di configurare percorsi complessi: basta specificare il nome del modello nella configurazione e LLaMA Factory si occuperà di scaricare tutto il necessario dal repository ufficiale. Questo processo è completamente trasparente e include non solo i pesi del modello ma anche i file di configurazione e i tokenizer necessari per il funzionamento corretto.

Ora devi configurare i parametri di training. Questa scelta è delicata: un learning rate troppo alto rischia di far dimenticare al modello le conoscenze generali acquisite durante il pre-training, mentre un learning rate troppo basso renderebbe l'apprendimento delle nuove informazioni estremamente lento. La community suggerisce di partire con learning rate nell'ordine di 10^-5 o 10^-4, aggiustando poi in base ai risultati che osservi.

Un aspetto particolarmente interessante di LLaMA Factory è il supporto per tecniche di training efficienti come LoRA e QLoRA. Queste metodologie ti permettono di effettuare il fine-tuning modificando solo una piccola frazione dei parametri del modello, riducendo drasticamente la memoria GPU necessaria. In pratica invece di aggiornare tutti i miliardi di parametri, LoRA introduce matrici di adattamento di rango ridotto che catturano le modifiche necessarie. Questo non solo rende possibile il training su Colab ma accelera anche il processo complessivo.

Implementa il Training su Google Colab

Google Colab è la piattaforma ideale per sperimentare con il fine-tuning senza dover investire in costose GPU dedicate. La versione gratuita offre accesso a GPU Tesla T4 che sono sufficienti per modelli di dimensioni medio-piccole, mentre le versioni a pagamento (Colab Pro e Pro+) forniscono GPU più potenti come A100 o V100 che fanno davvero la differenza con modelli più grandi.

Per iniziare crea un nuovo notebook su Colab e installa le dipendenze necessarie. LLaMA Factory può essere installato direttamente tramite pip insieme alle librerie di supporto come transformers, datasets e peft. Verifica che la versione CUDA installata sia compatibile con le versioni delle librerie per evitare problemi durante il training. Puoi controllare la GPU disponibile eseguendo il comando !nvidia-smi in una cella del notebook.

Il caricamento del dataset in Colab può avvenire in diversi modi. Se il dataset generato con Easy Dataset è di dimensioni contenute puoi caricarlo direttamente dal tuo computer usando l'interfaccia di upload di Colab. Per dataset più grandi è meglio utilizzare Google Drive come storage intermedio, montando il drive nel notebook e accedendo ai file da lì. Questo approccio ha il vantaggio di mantenere i dati persistenti anche se la sessione Colab viene terminata, evitandoti di dover ricaricare tutto ogni volta.

Durante il training è essenziale monitorare attentamente le metriche di loss e perplexity. LLaMA Factory fornisce strumenti di logging che ti permettono di visualizzare in tempo reale l'andamento del training. Una diminuzione costante della loss indica che il modello sta imparando correttamente, mentre oscillazioni o incrementi improvvisi potrebbero segnalare problemi con i parametri di training. Imposta checkpoint periodici che salvino lo stato del modello a intervalli regolari, così puoi recuperare il lavoro in caso di interruzioni della sessione.

Un aspetto importante quando lavori su Colab è la gestione del tempo di esecuzione. La versione gratuita ha limiti di utilizzo giornalieri e sessioni che possono essere interrotte dopo alcune ore di inattività. Per questo motivo pianifica il training in modo da completarlo entro i limiti di tempo disponibili.

Valida e Ottimizza il Modello

Una volta completato il training iniziale non puoi considerare il lavoro concluso. La fase di validazione è cruciale per verificare che il modello abbia effettivamente appreso la conoscenza desiderata senza perdere le capacità linguistiche generali. Crea un set di test separato dal dataset di training, contenente domande rappresentative ma non viste durante l'addestramento.

Testa il modello interrogandolo con varie formulazioni delle stesse domande e verifica la consistenza delle risposte. Un buon chatbot specializzato deve essere in grado di rispondere correttamente anche quando la domanda viene posta in modi diversi o con sinonimi. Se noti lacune o risposte imprecise potrebbe essere necessario arricchire il dataset di training con esempi aggiuntivi che coprano quelle specifiche aree di conoscenza.

L'ottimizzazione iterativa è spesso necessaria. Questo può significare regolare i parametri di training, aumentare il numero di epoche o modificare la composizione del dataset. Ti consiglio di iniziare con un subset ridotto del dataset completo per verificare rapidamente che la pipeline funzioni correttamente, per poi scalare all'intero dataset una volta confermato che il processo è solido. Questo approccio ti fa risparmiare tempo e risorse di computazione.

Deploy del Modello e Considerazioni Finali

Il modello fine-tuned può essere esportato e deployato in vari modi. LLaMA Factory facilita l'esportazione in formati compatibili con framework di inferenza popolari come vLLM o Text Generation Inference. Per applicazioni con vincoli di risorse puoi quantizzare il modello riducendone la precisione numerica da 16 bit a 8 o addirittura 4 bit, con un impatto spesso minimo sulla qualità delle risposte ma con benefici sostanziali in termini di memoria e velocità di esecuzione.

Il fine-tuning di modelli LLM per chatbot specializzati rappresenta un'alternativa potente al RAG, specialmente quando la base di conoscenze è ben definita e non cambia frequentemente. La combinazione di Easy Dataset per la preparazione dei dati e LLaMA Factory per il training, il tutto eseguibile su Google Colab, rende questa tecnologia accessibile anche se non disponi di infrastrutture enterprise. Il risultato è un chatbot che non solo risponde accuratamente alle domande nel suo dominio di competenza ma lo fa con la naturalezza e la fluidità di un modello linguistico all'avanguardia, avendo la conoscenza letteralmente integrata nella sua architettura neurale.

Bene! Ora hai tutti gli strumenti per creare il tuo chatbot specializzato tramite fine-tuning. Buon lavoro con il tuo progetto!